Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

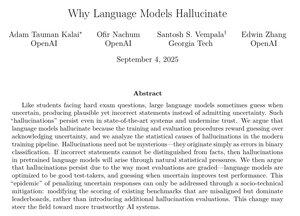

Dit OpenAI-document bevat enkele zeer overtuigende uitleggen over waarom hallucinaties aanhouden en wat we eraan kunnen doen.

Specifiek in de post-training zouden we moeten stoppen met het straffen van modellen voor het zeggen dat ze het antwoord niet weten, en moeten we stoppen met het belonen van te zelfverzekerd gokken.

Het uitroeien van hallucinaties zou een van de grootste AI-verbeteringen zijn voor zakelijke toepassingen zoals recht, financiën, gezondheidszorg en vele andere hoogwaarde gebieden.

Dit zou een zeer grote zaak zijn als we aanzienlijke vooruitgang in dit gebied kunnen blijven boeken.

50,07K

Boven

Positie

Favorieten